本文最后更新于:2025年1月12日 凌晨

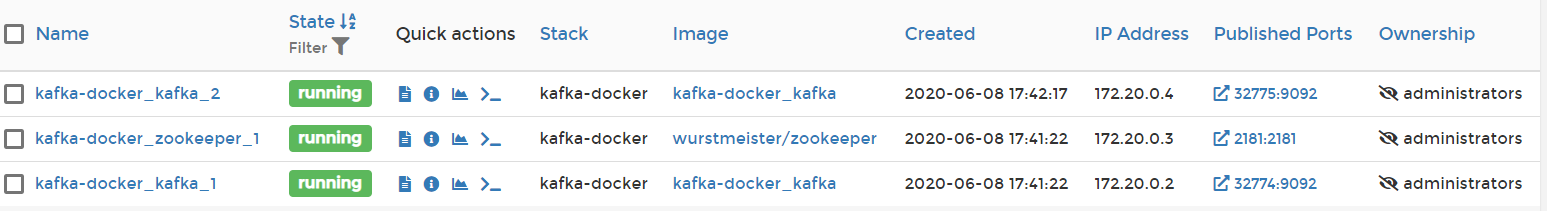

测试环境 由于是本地测试,我这里使用的是自己的专门用来测试的云服务器,参考我早前的博客Docker快速搭建Kafka开发环境 。

大概的情况如下:

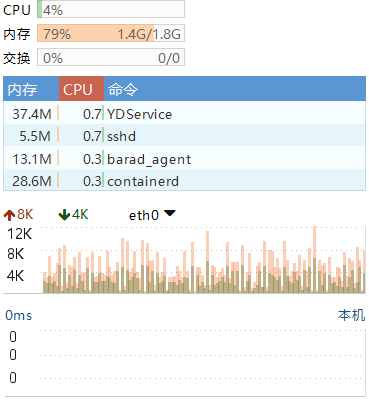

负载情况:

服务器上暂时没有跑其他的服务,基本跑起来一个zookeeper和两个kafka的节点,已经占去了1.5G的内存。。。所以一般也是用完就给关了

aiokafka 安装:

注意:

1 aiokafka 需要 kafka-python 库.

快速开始 消费者:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 from aiokafka import AIOKafkaConsumerimport asyncio"106.53.201.23" 32775 async def consume ():'my_topic' , 'my_other_topic' ,f'{KAFKAIP} :{KAFKAPORT} ' ,"my-group" )await consumer.start()try :async for msg in consumer:print ("consumed: " , msg.topic, msg.partition, msg.offset,finally :await consumer.stop()

生产者:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 from aiokafka import AIOKafkaProducerimport asyncioimport time"106.53.201.23" 32775 async def sender (producer: AIOKafkaProducer( ):await producer.send("my_topic" , b"Super message" )async def send_one ():f'{KAFKAIP} :{KAFKAPORT} ' )await producer.start()try :for i in range (1000 ):await asyncio.wait(task_list)print (c_time - s_time) finally :await producer.stop()